هوش مصنوعی و آینده جنگ ها

هوش مصنوعی و آینده جنگ ها -کارشناسان توافق دارند که جنگ آینده با استفاده از فناوری های تقویت شده با هوش مصنوعی (AI)، به ویژه سیستم های تسلیحاتی کاملاً خودمختار مشخص می شود.

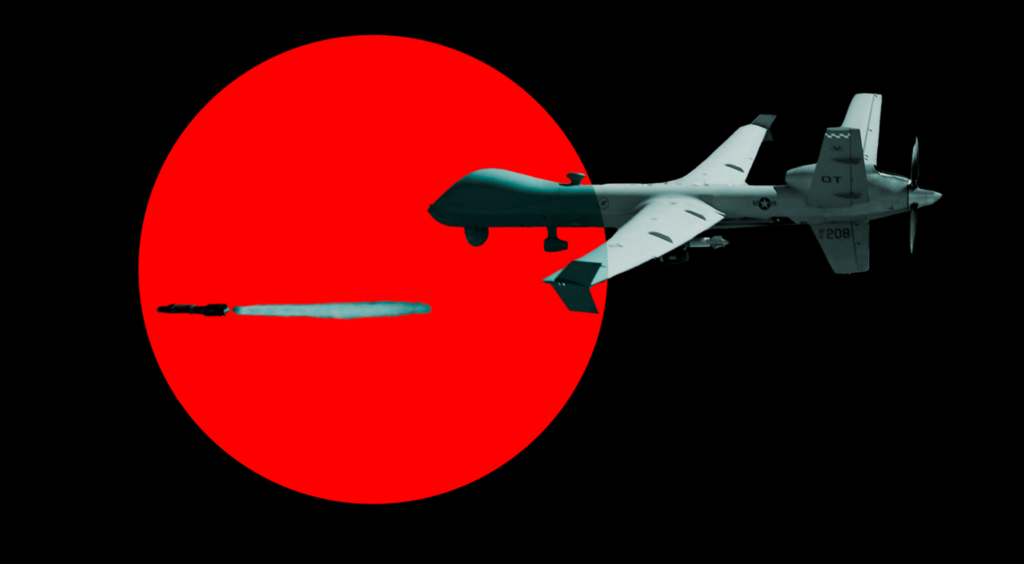

این قابلیتها – مانند هواپیمای بدون سرنشین ” وفادار وینگمن ” نیروی هوایی ایالات متحده یا هواپیمای بدون سرنشین – قادر به شناسایی، ردیابی و تعقیب اهداف بدون نظارت انسان هستند.

استفاده اخیر از این سیستمهای تسلیحاتی خود مختار مرگبار در درگیریها – از جمله در غزه ، لیبی ، قرهباغ کوهستانی و اوکراین – مسائل حقوقی ، اخلاقی و اخلاقی مهمی را مطرح میکند .

علیرغم استفاده از آنها، هنوز مشخص نیست که چگونه فناوری های نظامی تقویت شده با هوش مصنوعی می توانند ماهیت و پویایی جنگ را تغییر دهند.

کسانی که بیشتر نگران استفاده از هوش مصنوعی برای مقاصد نظامی هستند، آینده ای دیستوپیایی یا “آخرالزمان هوش مصنوعی” را پیش بینی می کنند که در آن ماشین ها به اندازه کافی بالغ می شوند تا بر جهان تسلط پیدا کنند.

یک تحلیلگر سیاسی حتی پیشبینی میکند که سیستمهای تسلیحاتی خودمختار مرگبار «به یک تغییر لرزهای در نظم جهانی به مراتب بزرگتر از آنچه با معرفی سلاحهای هستهای رخ داد منجر خواهد شد».

سایر ناظران با توجه به پیچیدگی مدلسازی هوش بیولوژیکی از طریق الگوریتمها ، این سوال را مطرح میکنند که تا چه حد سیستمهای هوش مصنوعی میتوانند به طور واقعی انسانها را تسخیر کنند .

با فرض اینکه چنین گسترش هوش مصنوعی امکان پذیر باشد، نظامیانی که به آن متکی هستند، متحمل هزینه های داده ها و قضاوت می شوند که احتمالاً «عنصر انسانی در جنگ را حتی مهم تر می کند، نه کمتر».

اگرچه در بحث درباره اثرات بالقوه هوش مصنوعی بر سیاست جهانی مفید است ، اما این دیدگاهها توضیح نمیدهند که چگونه هوش مصنوعی میتواند رفتار جنگ را تغییر دهد و سربازان در مورد این موضوع چه فکر میکنند.

برای مقابله با این مشکل، اخیراً بررسی کردم که چگونه فناوریهای نظامی تقویتشده با هوش مصنوعی – که در سطوح مختلف تصمیمگیری و انواع نظارت یکپارچه شدهاند – اعتماد افسران ارتش ایالات متحده را به این سیستمها شکل میدهند، که به درک آنها از مسیر جنگ اطلاع میدهد. در زمینه هوش مصنوعی، اعتماد به عنوان این باور تعریف میشود که یک فناوری مستقل در تعقیب اهداف مشترک، به طور قابل اعتمادی مطابق انتظار عمل میکند.

برای اندازهگیری سطح اعتماد ارتش به سیستمهای تسلیحاتی مرگبار، من نگرش افسرانی را که در کالج جنگ ارتش ایالات متحده در کارلایل، پنسیلوانیا، و کالج جنگ نیروی دریایی ایالات متحده در نیوپورت، رود آیلند حضور داشتند، مطالعه کردم.

این افسران، که ارتش از صفوف آنها ژنرال ها و دریاسالارهای آینده خود را انتخاب خواهد کرد، مسئول مدیریت یکپارچگی و استفاده از قابلیت های نوظهور در طول درگیری های آینده هستند.

بنابراین، نگرشهای آنها برای درک میزانی که هوش مصنوعی میتواند عصر جدیدی از جنگ را که توسط ارتشهای «وارباتها» انجام میشود، شکل دهد، مهم است.

تحقیقات من سه یافته کلیدی را نشان می دهد.

اولاً، افسران بسته به سطح تصمیم گیری که در آن یکپارچه شده اند و نوع نظارت بر قابلیت های جدید، به فناوری های نظامی تقویت شده با هوش مصنوعی اعتماد متفاوتی دارند.

دوم، افسران میتوانند پذیرش فناوریهای نظامی تقویتشده با هوش مصنوعی را تأیید یا حمایت کنند، اما به آنها اعتماد نکنند، که نشاندهنده ناهماهنگی نگرشها است که پیامدهایی برای مدرنسازی نظامی دارد.

سوم، نگرش افسران نسبت به قابلیتهای مجهز به هوش مصنوعی میتواند توسط عوامل دیگری نیز شکل بگیرد، از جمله باورهای اخلاقی، نگرانیها در مورد مسابقه تسلیحاتی هوش مصنوعی و سطح تحصیلات.

این یافتهها با هم، اولین شواهد تجربی از نگرش نظامی نسبت به هوش مصنوعی در جنگ را ارائه میکنند که پیامدهایی برای مدرنسازی نظامی، نظارت بر سیاستهای تسلیحات خودمختار، و آموزش نظامی حرفهای، از جمله برای فرماندهی و کنترل هستهای دارد.

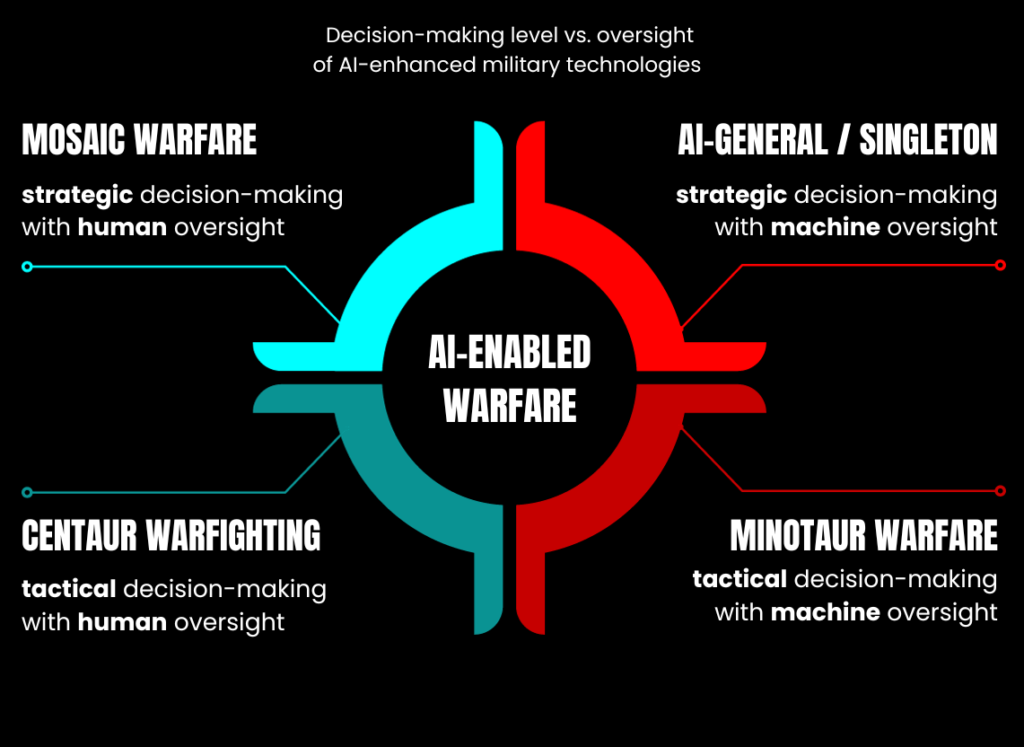

چهار نوع جنگ با هوش مصنوعی

پذیرش فناوریهای نظامی تقویتشده با هوش مصنوعی توسط کشورهای مختلف میتواند از نظر سطح تصمیمگیری (تاکتیکی یا استراتژیک) و نوع نظارت (انسان یا ماشین) متفاوت باشد.

کشورها می توانند الگوریتم ها را برای انجام عملیات تاکتیکی در میدان نبرد یا انجام مذاکرات استراتژیک در حمایت از اهداف کلی جنگ بهینه کنند.

از نظر تاکتیکی، چنین فناوریهایی میتوانند با تجزیه و تحلیل سریع مقادیر زیادی از دادههای گرفتهشده از حسگرهای توزیعشده در سراسر میدان نبرد، مرگبار بودن فرماندهان میدانی را افزایش دهند تا گزینههای هدفگیری سریعتر از دشمنان ایجاد شود.

همانطور که جان لیندسی، کارشناس امنیت سایبری می گوید ، “مبارزه ممکن است به عنوان یک بازی مدل شود که با از بین بردن دشمنان بیشتر و حفظ بازی های دوستانه بیشتر، برنده می شود.”

این با کوتاه کردن قابل توجه جدول زمانی « حسگر به تیرانداز »، که مربوط به فاصله زمانی بین دستیابی و تعقیب یک هدف است، به دست میآید.

گروه ویژه وزارت دفاع ایالات متحده لیما و پروژه ماون هر دو نمونههایی از این برنامههای هوش مصنوعی هستند.

از نظر استراتژیک، فناوریهای نظامی تقویتشده با هوش مصنوعی میتوانند به رهبران سیاسی و نظامی کمک کنند تا اهداف کلیدی (پایانها) را با ترکیبی از رویکردهای جنگی (راهها) و منابع (وسایل) محدود، از جمله مواد و پرسنل، هماهنگ کنند.

قابلیتهای جدید حتی میتواند ظاهر شود و جایگزین انسانها در عملیاتهای نظامی آینده شود، از جمله برای ایجاد جهت استراتژیک و استراتژیهای سطح ملی.

همانطور که یکی از کارشناسان استدلال میکند ، هوش مصنوعی قبلاً پتانسیل «درگیر شدن در تحلیلها و استراتژیهای پیچیده قابل مقایسه با آنچه برای آغاز جنگ لازم است» را نشان داده است.

در عین حال، کشورها همچنین می توانند نوع نظارت یا کنترل واگذار شده به فناوری های نظامی تقویت شده با هوش مصنوعی را کالیبره کنند.

این فناوریها را میتوان به گونهای طراحی کرد که امکان نظارت بیشتر انسانی را فراهم کند و اختیارات بیشتری را در تصمیمگیری فراهم کند.

چنین سیستم هایی اغلب نیمه مستقل نامیده می شوند، به این معنی که تحت کنترل انسان باقی می مانند . این الگوی نظارت مشخص می کند که چگونه اکثر سیستم های تسلیحاتی تقویت شده با هوش مصنوعی، مانند پهپاد جنرال اتمیکس MQ-9 Reaper ، در حال حاضر عمل می کنند.

در حالی که Reaper می تواند با خلبان خودکار پرواز کند و تغییرات توپوگرافی و شرایط آب و هوایی را برای تنظیم ارتفاع و سرعت خود در نظر بگیرد، انسان ها همچنان تصمیمات هدف گیری را می گیرند.

کشورها همچنین می توانند فناوری های نظامی تقویت شده با هوش مصنوعی را با نظارت کمتر انسانی طراحی کنند.

این سیستمها اغلب بهعنوان «رباتهای قاتل» شناخته میشوند، زیرا انسان از حلقه دور است . در این برنامهها، انسانها نظارت محدود، در صورت وجود، حتی برای هدفگیری تصمیمها را اعمال میکنند.

تنوع در سطح تصمیمگیری و نوع نظارت، چهار نوع جنگ را نشان میدهد که با توجه به پذیرش فناوریهای نظامی تقویتشده با هوش مصنوعی، میتواند در سطح جهانی ظهور کند.

چهار نوع جنگ با هوش مصنوعی

اول، کشورها می توانند از فناوری های نظامی تقویت شده با هوش مصنوعی برای تصمیم گیری تاکتیکی با نظارت انسانی استفاده کنند .

این چیزی را تعریف میکند که پل شار آن را « جنگ قنطورس » مینامد، که از نام موجودی از اساطیر یونان با بالاتنه انسان و پایینتنه و پاهای اسب گرفته شده است.

جنگ سنتور بر کنترل انسان بر ماشینها برای مقاصد میدان نبرد، مانند انهدام هدفی مانند انبار تسلیحات دشمن تأکید دارد.

دوم، کشورها می توانند از فناوری های نظامی تقویت شده با هوش مصنوعی برای تصمیم گیری تاکتیکی با نظارت ماشینی استفاده کنند .

این جنگهای سنتوری را روی سرش میچرخاند، به معنای واقعی کلمه، موجودی افسانهای دیگر از یونان باستان را تداعی میکند – مینوتور، با سر و دم گاو نر و بدن یک مرد. ” جنگ مینوتور ” با کنترل ماشینی انسان ها در طول نبرد و در سراسر حوزه ها مشخص می شود که می تواند از گشت زنی سربازان روی زمین گرفته تا صور فلکی کشتی های جنگی در اقیانوس تا تشکیلات جت های جنگنده در هوا را شامل شود.

سوم، تصمیمگیری استراتژیک ، همراه با نظارت ماشینی ، یک نوع جنگ « عمومی هوش مصنوعی » یا « تک نفره » را شکل میدهد.

این رویکرد، فناوریهای نظامی تقویتشده با هوش مصنوعی را با عرض جغرافیایی فوقالعاده برای شکلدهی مسیر نبرد کشورها سرمایهگذاری میکند، اما ممکن است پیامدهای جدی برای تعادل تهاجمی-دفاعی بین کشورها در طول درگیری داشته باشد.

به عبارت دیگر، یک نوع نبرد عمومی مبتنی بر هوش مصنوعی میتواند به کشورها این امکان را بدهد که در زمان و مکان نسبت به دشمنان برتری کسب کرده و حفظ کنند که نتایج کلی جنگ را شکل میدهند.

در نهایت، « جنگ موزاییک » نظارت انسانی بر فناوریهای نظامی تقویتشده با هوش مصنوعی را حفظ میکند، اما تلاش میکند از الگوریتمهایی برای بهینهسازی تصمیمگیری استراتژیک برای تحمیل و بهرهبرداری از آسیبپذیریها در برابر دشمن همتا استفاده کند.

هدف از این مدل جنگی – که جان آلن ژنرال (بازنشسته) تفنگداران دریایی ایالات متحده آن را ” هیپرجنگ ” می نامد و محققان اغلب از آن به عنوان سیستم های پشتیبانی تصمیم گیری الگوریتمی یاد می کنند – حفظ نظارت کلی انسان در حین استفاده از الگوریتم ها برای انجام وظایف توانمندسازی حیاتی است.

اینها شامل پیشبینی دورههای اقدام احتمالی دشمن از طریق فرآیند « پیشبینی لحظهای تهدید » (که مأموریت سیستم مخزن سریع تحلیلی با کمک ماشینی جدید وزارت دفاع یا MARS است )، شناسایی امکانپذیرترین، قابل قبولترین، و استراتژی مناسب (که شرکتهایی مانند Palantir و Scale AI در حال مطالعه چگونگی انجام آن هستند)، و کارکردهای جنگی کلیدی، مانند لجستیک ، برای کمک به ارتش برای به دست آوردن و حفظ ابتکار عمل در محیطهای عملیاتی مورد مناقشه که با خطوط تدارکات گسترده مشخص میشوند، طراحی کنند. به عنوان هند و اقیانوس آرام.

نگرش افسران آمریکایی نسبت به جنگ با هوش مصنوعی

برای پرداختن به اینکه افسران نظامی چگونه به فناوریهای نظامی تقویتشده هوش مصنوعی با توجه به تنوع در سطح تصمیمگیری و نوع نظارت اعتماد میکنند، در اکتبر 2023 نظرسنجی را در میان افسران منصوب در کالجهای جنگ در کارلایل و نیوپورت انجام دادم.

این نظرسنجی شامل چهار گروه آزمایشی بود که استفاده از فناوری نظامی تقویتشده با هوش مصنوعی را از نظر تصمیمگیری (تاکتیکی یا استراتژیک) و نظارت (انسان یا ماشین) و همچنین یک گروه پایه که این ویژگیها را دستکاری نکردند، متفاوت بودند.

پس از خواندن سناریوهای تخصیص تصادفی آنها، از پاسخ دهندگان خواستم که اعتماد و حمایت خود را در این قابلیت در مقیاس یک (کم) تا پنج (بالا) ارزیابی کنند. سپس داده ها را با استفاده از روش های آماری تجزیه و تحلیل کردم.

اگرچه نمونه من نماینده ارتش ایالات متحده (و نه شاخه های آن، مانند ارتش و نیروی دریایی ایالات متحده) نیست، اما دانشمندان علوم سیاسی آن را نمونه مناسب می نامند.

این کمک می کند تا بینش های بسیار نادری در مورد اینکه چگونه اعضای ارتش ممکن است به فناوری های نظامی تقویت شده با هوش مصنوعی و تأثیر این اعتماد بر شخصیت جنگ اعتماد کنند، به دست آوریم.

این نمونه همچنین آزمون سختی برای درک من از تغییرات احتمالی در آینده جنگ با توجه به ظهور هوش مصنوعی است، زیرا من از افسران درجه میدانی، از جمله سرگردها/سپهمانان، سرهنگ دوم/فرماندهان، و سرهنگ/کاپیتان بیش از حد نمونه برداری کردم.

آنها سالها آموزش دارند و در هدفگیری متخصص هستند و بسیاری برای نبرد مستقر شدهاند و درباره پهپادها تصمیمگیری کردهاند.

آنها همچنین رهبران ارشد در حال ظهور هستند که به آنها سپرده شده است تا پیامدهای فناوری های جدید را برای درگیری های آینده ارزیابی کنند.

این ویژگیها نشان میدهد که افسران نمونه من ممکن است نسبت به سایر بخشهای ارتش، بهویژه افسران جوان که اغلب به عنوان « بومیهای دیجیتال » شناخته میشوند، به فناوریهای نظامی تقویتشده هوش مصنوعی بیاعتماد باشند .

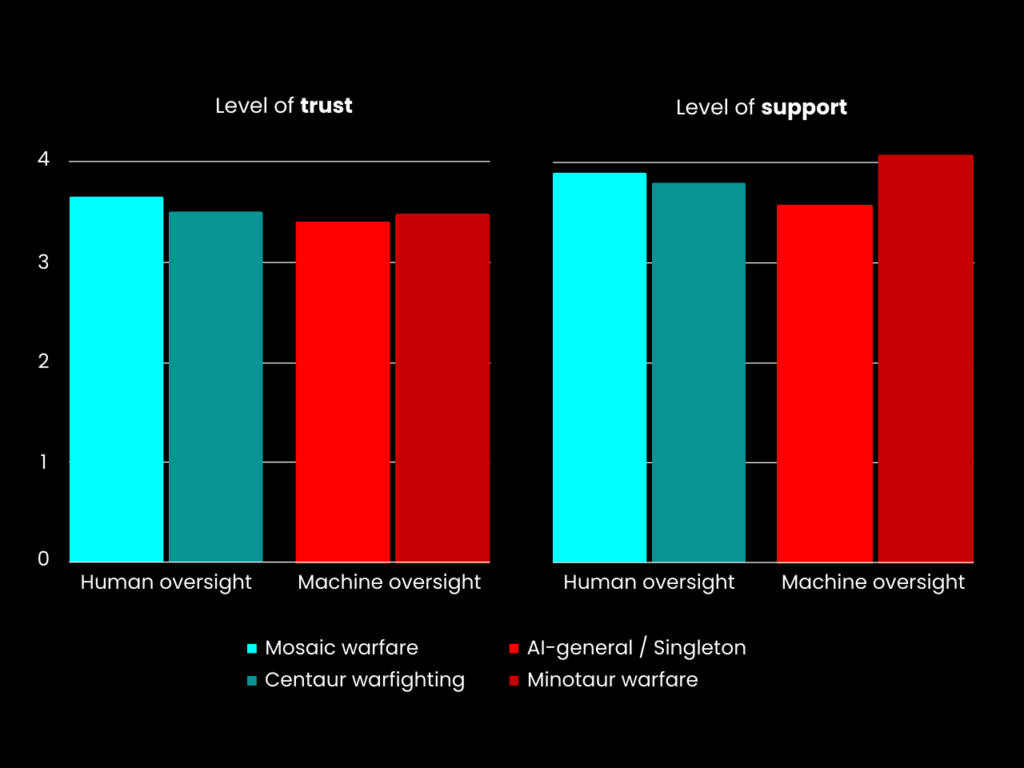

این نظرسنجی چندین یافته کلیدی را نشان می دهد. اولاً، افسران می توانند بر اساس تنوع در سطح تصمیم گیری و نوع نظارت بر این قابلیت های جدید، به فناوری های نظامی تقویت شده با هوش مصنوعی به روش های مختلف اعتماد کنند.

در حالی که افسران عموماً به انواع مختلف سلاحهای تقویتشده هوش مصنوعی بیاعتماد هستند، اما کمترین اعتماد را به قابلیتهای مورد استفاده برای جنگ تکنفره (تصمیمگیری استراتژیک با نظارت ماشینی) دارند.

از سوی دیگر، آنها اعتماد بیشتری به جنگ موزاییک (نظارت انسانی بر تصمیم گیری استراتژیک بهینه سازی شده با هوش مصنوعی) نشان می دهند.

این نشان می دهد که افسران به طور مداوم کنترل انسانی هوش مصنوعی را برای شناسایی الگوهای ظریف در فعالیت دشمن، ایجاد گزینه های نظامی برای ارائه یک دشمن با معضلات متعدد یا کمک به حفظ آمادگی جنگی در طول درگیری طولانی ترجیح می دهند.

در مقایسه با گروه پایه، اعتماد افسران به فنآوریهای نظامی مجهز به هوش مصنوعی از نظر جنگ تک تن (18.8 درصد) نسبت به جنگ موزاییکی (10.5 درصد) کاهش مییابد – شکل 1 را ببینید .

در حالی که تفاوت در سطح میانگین اعتماد افسران در مقایسه با گروه پایه از نظر آماری برای هر دو نوع جنگ تقویتشده هوش مصنوعی معنیدار است، این تفاوتها برای قابلیتهای نظامی جدید که برای جنگهای تک نفره استفاده میشوند بیشتر از جنگ موزاییکی هستند.

همچنین، میانگین تغییر در احتمال اعتماد افسران در هر دو نوع جنگ تقویتشده هوش مصنوعی (یعنی میانگین تأثیر حاشیهای فناوریهای نظامی تقویتشده با هوش مصنوعی بر اعتماد افسران) تنها از نظر آماری برای جنگ تک نفره معنادار است.

به طور کلی، این نتایج نشان میدهد که افسران نسبت به فناوریهای نظامی تقویتشده هوش مصنوعی که با نظارت انسانی برای کمک به تصمیمگیری در سطوح بالاتر استفاده میشوند، بیاعتماد کمتری دارند.

این نتایج برای سطوح اعتماد تا حد زیادی با نگرش افسران در حمایت منعکس می شود.

افسران پشتیبانی کمتری از فناوریهای نظامی تقویتشده با هوش مصنوعی مورد استفاده برای جنگهای تک تن در مقایسه با گروه پایه نشان میدهند و تقریباً در همان سطح – 18.3 درصد – و درجه اهمیت آماری هستند.

با این حال، در مقایسه با گروه پایه، افسران نیز بیشتر از سایر الگوهای جنگ تقویتشده هوش مصنوعی، با تغییر در سطح پشتیبانی حدود 6.5 درصد، از جنگ مینوتوری پشتیبانی میکنند.

این نشان میدهد که در حالی که افسران ممکن است نسبت به فناوریهای نظامی تقویتشده هوش مصنوعی که در سطوح بالاتر تصمیمگیری و با کنترل انسانی گنجانده شده است، بیاعتماد کمتری داشته باشند، آنها بیشتر از فناوریهای نظامی تقویتشده هوش مصنوعی که برای تصمیمگیری در سطح تاکتیکی و با نظارت ماشینی استفاده میشوند، حمایت میکنند.

در مجموع، به نظر می رسد نگرش افسران منعکس کننده استدلال کنت پین، پروفسور کالج کینگز است که می گوید: «وارربات ها جنگجویان باورنکردنی، اما استراتژیست های محدودی خواهند ساخت».

شکل 1. اعتماد و حمایت نسبت به گروه پایه برای چهار نوع جنگ با هوش مصنوعی. توجه: مقادیر نشان دهنده تغییرات در سطوح پشتیبانی و اعتماد برای فناوری های نظامی تقویت شده با هوش مصنوعی توسط گروه های درمانی در مقایسه با گروه پایه است. هنگامی که سطوح حمایت و اعتماد در مقایسه با گروه پایه کاهش می یابد، مقادیر منفی هستند. (داده ها: پل لوشنکو. تجسم: فرانسوا دیاز-مورن)

پشتیبانی نسبتاً بالاتر افسران از استفاده در سطح تاکتیکی از فناوریهای نظامی تقویتشده با هوش مصنوعی، دومین یافته کلیدی را نشان میدهد.

نگرش افسران نسبت به فناوریهای نظامی تقویتشده با هوش مصنوعی میتواند بیشتر برای حمایت آشکار باشد تا اعتماد. این به معنای چیزی است که برخی از محققان آن را ” پارادوکس اعتماد ” می نامند.

به نظر می رسد افسران از پذیرش فناوری های جدید میدان نبرد که با هوش مصنوعی تقویت شده اند حمایت می کنند – حتی اگر لزوماً به آنها اعتماد نداشته باشند.

این پدیده بیشتر به جنگ مینوتوری (استفاده از هوش مصنوعی برای تصمیم گیری در سطح تاکتیکی و با نظارت ماشین) مربوط می شود.

این نشان میدهد که افسران انتظار دارند که فناوریهای نظامی تقویتشده با هوش مصنوعی، زمان و فضای مانور دشمن را از بین ببرد و در عین حال مانور ارتش ایالات متحده را گسترش دهد، که براساس یک جدول زمانی کوتاهشده «حسگر به تیرانداز» است که رهبران ارشد نظامی معتقدند کلید شکست دادن است. دشمنان نزدیک در درگیری های آینده

تنوع در میزان حمایت افسران از فناوریهای نظامی تقویتشده با هوش مصنوعی که برای تصمیمگیری در سطح تاکتیکی و با نظارت ماشینی استفاده میشود، بیشتر از تغییر در اعتماد آنهاست ( شکل 2 ).

علاوه بر این، نتایج نشان میدهد که تفاوت در نگرش افسران نسبت به اعتماد و پشتیبانی از نظر آماری معنیدار است: افسران از فناوریهای نظامی تقویتشده با هوش مصنوعی که برای جنگهای مینوتور استفاده میشوند، بیشتر از اینکه به آنها اعتماد کنند، پشتیبانی میکنند.

میانگین تغییر احتمال اینکه افسران از فناوریهای نظامی تقویتشده با هوش مصنوعی که برای جنگهای مینوتوری استفاده میشوند پشتیبانی کنند نیز بیشتر از سه نوع دیگر جنگ با هوش مصنوعی است.

در مجموع، این نتایج نشاندهنده عدم همسویی باورها در حمایت و اعتماد افسران آمریکایی نسبت به فناوریهای نظامی تقویتشده هوش مصنوعی است.

با وجود حمایت از پذیرش چنین فناوریهایی برای بهینهسازی تصمیمگیری در سطوح مختلف و درجات نظارت، افسران به انواع جنگهای احتمالی ناشی از آن به دلیل قابلیتهای نوظهور مجهز به هوش مصنوعی اعتماد ندارند.

این نتیجه نشان میدهد که افسران ایالات متحده ممکن است احساس کنند موظف به پذیرش اشکال پیشبینیشده جنگ هستند که برخلاف ترجیحات و نگرشهای خودشان است، بهویژه جنگ مینوتوری که اساس مفاهیم جنگی نوظهور ارتش و نیروی دریایی ایالات متحده است .

شکل 2. اعتماد و پشتیبانی از چهار نوع جنگ با هوش مصنوعی. توجه: مقادیر نشان دهنده میانگین سطوح حمایت و اعتماد برای فناوری های نظامی تقویت شده با هوش مصنوعی توسط گروه های درمانی است. (داده ها: پل لوشنکو. تجسم: فرانسوا دیاز-مورن)

عوامل دیگر تنوع در اعتماد افسران به فناوری های نظامی تقویت شده با هوش مصنوعی را بیشتر توضیح می دهند.

در نظرسنجی من، هنگام کنترل تنوع در سطح تصمیمگیری و نوع نظارت، متوجه شدم که نگرش افسران در قبال این فناوریها نیز میتواند با ملاحظات اخلاقی، ابزاری، و آموزشی شکل بگیرد.

افسرانی که معتقدند ایالات متحده تعهد اخلاقی به استفاده از فناوری های نظامی تقویت شده با هوش مصنوعی در خارج از کشور دارد، نشان دهنده درجه بالاتری از اعتماد به این قابلیت های جدید میدان نبرد است که با نگرش های پشتیبانی نیز سازگار است.

این نشان میدهد که باورهای اخلاقی افسران برای مزایای بالقوه فناوریهای نظامی تقویتشده هوش مصنوعی که در خارج از کشور استفاده میشوند، مانند طی عملیاتهای کمکهای بشردوستانه و امدادرسانی در بلایا، ممکن است به غلبه بر بیاعتمادی ذاتی آنها در پذیرش این قابلیتها کمک کند.

علاوه بر این، افسرانی که برای فناوریهای نظامی تقویتشده با هوش مصنوعی ارزش ابزاری قائل هستند و نگرش «ترس از دست دادن» را نسبت به آنها تجربه میکنند – یعنی معتقدند که پذیرش سایر کشورها از چنین فناوریهایی، ایالات متحده را نیز مجبور میکند آنها را اتخاذ کند، مبادا در یک مسابقه تسلیحاتی بالقوه هوش مصنوعی ضعیف است – همچنین تمایل دارد به این قابلیت های در حال ظهور اعتماد بیشتری داشته باشد.

نگرش های مشابهی از اعتماد هنگام در نظر گرفتن آموزش مشاهده می شود. نتایج نشان میدهد که آموزش عالی اعتماد افسران را به فناوریهای نظامی تقویتشده با هوش مصنوعی کاهش میدهد، به این معنی که دانش بیشتر یا تخصصیتر سؤالاتی را در مورد شایستگی و محدودیتهای هوش مصنوعی در طول جنگ آینده ایجاد میکند.

در نهایت، در تلاقی این ملاحظات هنجاری و ابزاری، متوجه شدم افسرانی که معتقدند نیروی نظامی برای حفظ نظم جهانی ضروری است، از استفاده از فناوریهای نظامی تقویتشده با هوش مصنوعی نیز بیشتر حمایت میکنند.

این نتایج با هم، تحقیقات قبلی را تقویت می کند که نشان می دهد جهان بینی افسران نگرش آنها را نسبت به فن آوری های میدان نبرد شکل می دهد و افسران می توانند منطق های مختلفی را هنگام ارزیابی اعتماد و حمایت خود از استفاده از زور در خارج از کشور ادغام کنند.

چگونه افسران را برای جنگ با هوش مصنوعی بهتر آماده کنیم؟

این اولین شواهد در مورد نگرش افسران ارتش ایالات متحده نسبت به هوش مصنوعی تصویر پیچیده تری از ماهیت در حال تحول جنگ به دلیل فناوری های نوظهور را نسبت به آنچه که برخی از تحلیلگران اجازه می دهند ارائه می دهد.

با این حال، این نگرشها پیامدهایی برای مدرنسازی و سیاستهای جنگ و آموزش نظامی حرفهای افسران، از جمله برای مدیریت سلاحهای هستهای دارد.

اول، اگرچه برخی از رهبران نظامی ایالات متحده ادعا می کنند که “ما شاهد یک تغییر لرزه ای در ماهیت جنگ هستیم که عمدتاً دوباره توسط فناوری هدایت می شود”، ظهور فناوری های نظامی تقویت شده با هوش مصنوعی در درگیری ممکن است بیشتر یک تحول باشد تا یک انقلاب.

در حالی که جنگهای غزه و اوکراین تغییرات مهمی را در نحوه مبارزه نظامیان نشان میدهند، این جنگها تداومهای کلیدی را نیز منعکس میکنند .

ارتش ها به طور سنتی به دنبال سرمایه گذاری بر روی فناوری های جدید برای افزایش اطلاعات خود، محافظت از نیروهای خود، و گسترش دامنه آتش تاکتیکی و عملیاتی خود بوده اند که ترکیب آنها باعث ایجاد ” عدم تقارن رادیکال ” در میدان نبرد می شود.

اخیراً، نشان داده شده است که تغییرات در نحوه استفاده و محدود کردن هواپیماهای بدون سرنشین توسط کشورها به درک عمومی از استفاده مشروع – یا نامشروع – از زور نیز شکل میدهد، نتیجهای که با فناوریهای نظامی کاملا خودمختار در حال ظهور سازگار است.

با این حال، پیامدهای این قابلیت ها و سایر قابلیت ها برای نتایج استراتژیک در جنگ در بهترین حالت مشکوک است .

موفقیت استراتژیک در طول جنگ هنوز تابعی از اراده کشورها برای قربانی کردن جان سربازان و دلارهای مالیات دهندگان برای دستیابی به اهداف سیاسی و نظامی است که از منافع ملی حیاتی حمایت می کند.

در واقع، افسران مطالعه من ممکن است از فناوریهای نظامی تقویتشده با هوش مصنوعی که برای جنگهای مینوتوری استفاده میشوند، بیشترین پشتیبانی را داشته باشند.

اما شرکت کنندگان در این مطالعه هنوز به طور کلی اعتماد و حمایت بسیار کمتری نسبت به فناوری های جدید میدان نبرد نشان دادند که با توجه به هیاهویی که نوآوری نظامی آنها را احاطه کرده بود -اگر نه مبالغه آمیز و ترس .

این نتایج نشان می دهد که رهبران نظامی باید انتظارات خود را در مورد پیامدهای پارادایماتیک هوش مصنوعی برای درگیری های آینده کاهش دهند.

به عبارت دیگر ، ما باید “آماده شویم تا از هوش مصنوعی ناامید شویم.” به گفته سرهنگ مایکل فرگوسن، سرهنگ دوم ارتش ایالات متحده ، فقدان چنین چشمانداز روشنی امکان ظهور «نظریههای مد روزی را که جنگ را به کابوکی از تعبیرها تبدیل میکند» و واقعیتهای خشن نبرد را مبهم میسازد.

این یک برخورد اراده است که به شدت انسانی و مشروط به اهداف سیاسی است.

دوم، نگرش افسران نسبت به فناوری های نظامی تقویت شده با هوش مصنوعی پیچیده تر از آن چیزی است که مطالعه من نشان می دهد.

در واقع، همانطور که یک سرهنگ سابق نیروی هوایی ایالات متحده و در حال حاضر تحلیلگر ستاد مشترک J-8 اشاره می کند ، برای اپراتورها دشوار است که با درجه احتمال بالایی پیش بینی کنند که چگونه یک سیستم واقعاً در برابر یک دشمن تطبیقی عمل می کند و به طور بالقوه اعتماد را از بین می برد.

در سیستم.» در مطالعهای که در حال انجام است، متوجه شدم که اعتماد افسران به فناوریهای نظامی تقویتشده با هوش مصنوعی میتواند با مجموعهای از ملاحظات شکل بگیرد.

اینها شامل مشخصات فنی، یعنی هدف غیر کشنده، دقت بالا، و نظارت انسانی است. اثربخشی درک شده از نظر حفاظت غیرنظامی، حفاظت از نیرو، و انجام ماموریت؛ و نظارت، از جمله مقررات داخلی اما به ویژه بین المللی.

در واقع، یکی از افسران در این مطالعه خاطرنشان کرد که اعتماد به فناوریهای نظامی تقویتشده با هوش مصنوعی مبتنی بر «انطباق با قوانین بینالمللی به جای قوانین داخلی ایالات متحده» است.

این نتایج نشان میدهد که نیاز به آزمایش و آزمایش بیشتر قابلیتهای جدید برای همسو کردن استفاده از آنها با انتظارات اعضای خدمات است.

سیاستگذاران و رهبران نظامی همچنین باید مفاهیم جنگ را روشن کنند که در آن توسعه فناوری های نظامی تقویت شده با هوش مصنوعی باید تشویق شود.

دکترین هدایت کننده ادغام آنها در حوزه های مختلف، در سطوح مختلف، و برای اهداف مختلف. و سیاست های حاکم بر استفاده از آنها.

برای این کار اخیر، مقامات باید توضیح دهند که سیاست ایالات متحده چگونه با قوانین بینالمللی منطبق است یا از آن فاصله میگیرد، و همچنین چه هنجارهایی استفاده از فناوریهای نظامی تقویتشده با هوش مصنوعی را مشروط میکنند ، با توجه به اینکه حداقل افسران در ردههای میدانی چگونه انتظار دارند.

از این قابلیت ها استفاده شود. برای پر کردن این شکاف، کاخ سفید اخیراً سیاست ایالات متحده را در مورد استفاده نظامی مسئولانه از هوش مصنوعی و عملکردها و سیستم های خودمختار اعلام کرد ، وزارت دفاع دستورالعملی را تصویب کرد که بر توسعه و استفاده از تسلیحات خودمختار در ارتش ایالات متحده حاکم است و پنتاگون نیز ایجاد کرد.

دفتر ارشد دیجیتال و هوش مصنوعی برای کمک به اجرای این دستورالعمل، اگرچه گزارش شده است که این دفتر با چالش های بودجه ای و پرسنلی مواجه است.

در نهایت، رهبران نظامی همچنین باید آموزش نظامی حرفه ای را برای آموزش افسران در مورد شایستگی ها و محدودیت های هوش مصنوعی اصلاح کنند.

آنها باید کاربرد هوش مصنوعی را در زمینه های استراتژیک دیگر، از جمله فرماندهی و کنترل هسته ای بررسی کنند.

بسیاری از ابتکارات در سراسر ارتش ایالات متحده در حال حاضر منعکس کننده این نیاز است، به ویژه با توجه به تردید افسران برای مشارکت با قابلیت های مجهز به هوش مصنوعی.

از نظر عملیاتی، ” Project Ridgeway ” به رهبری سپاه هجدهم هوابرد ارتش ایالات متحده، برای ادغام هوش مصنوعی در فرآیند هدفگیری طراحی شده است.

این با ” آملیا ” و “وفادار وینگمن” که برنامههای نیروی دریایی و نیروی هوایی هستند که برای بهینهسازی فرآیندهای کارکنان و جنگهای جنگی طراحی شدهاند، مطابقت دارد.

از نظر سازمانی، علاوه بر دورههای صدور گواهینامه از قبل موجود، برخی تحلیلگران ادغام ارزیابیهای سواد دادهای را در برنامههای ارزیابی مبتنی بر استعداد، مانند برنامه ارزیابی فرماندهی ارتش ایالات متحده، تشویق میکنند.

از نظر آموزشی، آکادمیهای خدماتی و کالجهای جنگ دارای هیئت علمی، مراکز تحقیقاتی و دروس انتخابی هستند که به مطالعه مفاهیم هوش مصنوعی برای جنگ آینده اختصاص دارند. کالج جنگ ارتش ایالات متحده اخیراً یک استاد علوم داده استخدام کرده است ، آکادمی نیروی دریایی ایالات متحده یک خوشه تحقیقاتی “سلاح، رباتیک و مهندسی کنترل” دارد و کالج جنگ نیروی دریایی ایالات متحده یک درس انتخابی “AI برای رهبران استراتژیک” ارائه می دهد .

MQ-9 Reaper که در اینجا در حال شلیک موشک هوا به زمین Missile-114 Hellfire دیده می شود، یک هواپیمای بدون خلبان کنترل از راه دور است که می تواند برای اطلاعات، شناسایی و حملات مورد استفاده قرار گیرد. (عکس: نیروی هوایی ایالات متحده. طراحی: François Diaz-Maurin)

در همان زمان، بازیهای جنگی که در کالج جنگ نیروی دریایی ایالات متحده و جاهای دیگر انجام شد ، نشان میدهد که قابلیتهای سایبری میتوانند اتوماسیون و تفویض پیش از فرماندهی و کنترل هستهای را به سطوح تاکتیکی فرماندهی تشویق کنند و راهبردهای ضد نیروی تهاجمی را تشویق کنند.

اما نتایج من نشان دهنده یک نتیجه گیج کننده است که سزاوار آزمایش بسیار بیشتری است. با در نظر گرفتن ارزش اسمی، و علیرغم اینکه نتایج میتواند مشابه استفاده از سلاحهای هستهای در جنگ باشد، نتایج یک سوال نگرانکننده را ایجاد میکند: آیا افسران واقعاً میتوانند از اتوماسیون بالقوه و تفویض اختیار فرماندهی و کنترل هستهای به هوش مصنوعی در سطح تاکتیکی، حتی اگر آنطور که نتایج من نشان میدهد، به آن اعتماد ندارند یا به استفاده از هوش مصنوعی برای کنترل استراتژیهای نیروی متقابل اعتماد ندارند یا از آن حمایت نمیکنند؟

در حالی که این نتیجه گیری ممکن است عجیب به نظر برسد – در تضاد با مجموعه ای از تحقیقات در مورد ” تابو ” هسته ای، تشدید بحران ، و تنها مقام ریاست جمهوری برای استفاده از این سلاح ها – تهدیدهای روسیه برای استفاده از سلاح های هسته ای در اوکراین، ارتش ایالات متحده را تشویق کرده است که این احتمال را دوباره بررسی کند .

استفاده محدود از سلاح های هسته ای در طول جنگ قدرت های بزرگ. علیرغم یا به دلیل پتانسیل ترسناک این سناریوی «بازگشت به آینده»، که بازتاب تکثیر تسلیحات هستهای تاکتیکی در طول جنگ سرد است، دانشکدههای جنگ ایالات متحده آموزش را برای آمادگی عملیاتی در طول تبادل تاکتیکی هستهای بین کشورهایی که درگیر درگیر هستند، تقویت کردهاند . تضاد مقیاس

با این حال، میزانی که این ابتکارات و سایر ابتکارات به طور مؤثر افسران را در زمینه هوش مصنوعی آموزش می دهند، مشخص نیست.

بخشی از مشکل این است که ابتکارات رویکردهای آموزشی رقیب را در برابر یکدیگر قرار می دهند.

برخی از برنامهها سواد دادهای و هوش مصنوعی را با رویکردی «عرض مایل، اینچ عمیق» بررسی میکنند که یک درس واحد را در یک دوره از یک برنامه درسی گستردهتر ادغام میکند. برنامههای دیگر فرصتهای توسعه بیشتر و رویکردی «محدود و عمیقتر» را فراهم میکنند، که در آن تعداد انگشت شماری از افسران بهطور داوطلبانه دروس انتخابی را انتخاب میکنند که در بالای برنامه درسی گستردهتر هستند.

سایر برنامهها، مانند برنامه کالج جنگ ارتش ایالات متحده، رویکرد «رشته طلایی» را امتحان میکنند، که سواد داده و هوش مصنوعی را در دورههایی که یک برنامه آموزشی گستردهتر را چارچوب میدهند، تعبیه میکند.

با این حال، این رویکرد اخیر، مدیران را مجبور میکند تا از نظر محتوا و زمان، معاوضههای مهمی انجام دهند و تخصص عمیق هیئت علمی را در نظر میگیرد.

در آینده، ستاد مشترک J-7 – اداره مسئول هماهنگی آموزش و آموزش در سراسر نیروی مشترک ایالات متحده – باید آموزش نظامی حرفه ای را به عنوان تداومی از غنی سازی پایدار و افزایشی در طول زمان از نظر سواد داده و آموزش هوش مصنوعی تصور کند.

دانشآموزان پیشفرض که در آکادمیهای خدماتی شرکت میکنند یا در سپاه آموزش افسران ذخیره شرکت میکنند باید با مفاهیم اساسی در مورد هوش مصنوعی آشنا شوند.

افسران درجه اول و متوسط باید این بینش ها را در طول آموزش، اعزام، و در حین شرکت در آموزش سطح متوسط، مانند دانشکده فرماندهی و ستاد کل ارتش ایالات متحده، ادغام کنند.

پس از انتخاب در دانشکده های جنگ، افسران باید با ملاحظات مفهومی، هنجاری و ابزاری حاکم بر استفاده از هوش مصنوعی در جنگ دست و پنجه نرم کنند، که مطالعه من نشان می دهد که می تواند نگرش نظامی را نسبت به فناوری های جدید شکل دهد.

البته اتخاذ این رویکرد آموزشی پایانی به زمان و هزینه نیاز دارد. همچنین در برابر امتیازات ذینفعان مختلف، فرهنگ های خدماتی و رقابت های بین خدماتی مسئول است .

با این حال، با همسو کردن آموزش و آموزش با نتایج یادگیری واضح و عملی، این مدل آموزشی جامع از فرصتهای موجود بهره میبرد تا اطمینان حاصل شود که ارتش ایالات متحده آماده و مایل به استفاده از فناوریهای نظامی تقویتشده هوش مصنوعی در زمان صلح و جنگهای آینده به روشهایی است که با بینالمللی همسو است.

قوانین و هنجارهای حاکم بر استفاده مشروع از آنها.